AUDEERING: DIE STIMME VERRÄT CORONA

Eine halbe Minute in das Smartphone sprechen, wenige Sekunden später steht das Corona-Testergebnis fest. Ob positiv oder negativ – Stimme und Klang der Sprache, selbst die Atmung geben Aufschluss über eine Infektion.

16. März 2021

Es muss nicht nur der Husten sein; Stimmenlappen, die nicht mehr synchron arbeiten, liefern Hinweise. Schon kleinste Merkmale sollen reichen, und die Symptome müssen nicht in vollem Umfang erkennbar sein. Bereits vor einem Jahr hat sich die im Jahr 2012 gegründete audEERING aus Gilching nahe München mit einem Stimmen-Coronatest auseinandergesetzt.

Sehr früh hatte sie Kontakte nach Wuhan, wo die Pandemie ausbrach. audEERING hat eine Software-Plattform auf Basis Künstlicher Intelligenz entwickelt, mit der Rechner oder Apps über die menschliche Stimme Emotionen und gesundheitliche Symptome erfassen können. Eigentlich wollte Dagmar Schuller den Corona-Stimmentest im Mai auf den Markt bringen.Doch benötigt die Vorstandsvorsitzende und Mitgründerin deutlich mehr Daten, um eine Zulassung als Massentest zu erhalten. Sie hofft nun auf den Sommer.

Dagmar Schuller und Florian Eyben Foto Rüdiger Köhn

„Für diesen Test benötigt man kein Fachpersonal“, spielt die 45 Jahre alte Vorstandschefin auf die derzeit gängigen Tests oder Schnelltests an, die inzwischen auch im Handel erhältlich sind. „Kein Spucken, Gurgeln oder Nasebohren mit Wattestäbchen, der Stimmentest ist eine komfortable Variante für Eltern, Lehrer oder Leute, die in Restaurants oder Geschäfte gehen wollen.“ Und er sei umweltfreundlich, lacht sie. „Da wird ziemlich viel Plastikmüll anfallen bei den jetzt verbreiteten Abermillionen Testkits aus dem Supermarkt.“ Noch wichtiger: Die Sprachanalyse über eine App kann auch Mutationen des Virus wahrnehmen.

Der Test ist jederzeit und ortsunabhängig möglich; bevor man etwa in ein Restaurant gehe, ein Flugzeug oder einen Zug besteige, wirbt Schuller. Die Stimmenanalyse ist für sie nur schwer mit den zur Zeit gängigen, mittlerweile auch in Supermärkten, Drogerien oder Apotheken erhältlichen Schnelltests vergleichbar. Wegen der so unterschiedlichen Herangehensweisen vermag sie nicht zu sagen, ob der eine oder andere Test sensibler als der andere ist.

Um das System zur Marktreife zu bringen, arbeitet audEERING seit längerem mit Universitäten und Forschungsinstituten zusammen, hat Kontakte zu Krankenhäusern und Testzentren. "Wir sind auch an verschiedene Ministerien auf Bundes- und Landesebene herangetreten, sogar schon im April 2020, als unsere ersten Ergebnisse angezeigt haben, dass die Testmethode eine gute Möglichkeit zur Pandemiebekämpfung ist", sagt die Vorstandschefin.

Zäher Zulassungsprozess

Dafür brauche es aber eine tragfähige Methode, um notwendige Daten im großen Umfang zu erheben und so die "Erkennungsleistung und Validierung" des Test zu verbessern. "Wir haben hier ein Konzept vorgeschlagen und hoffen, dass wir das realisieren können."

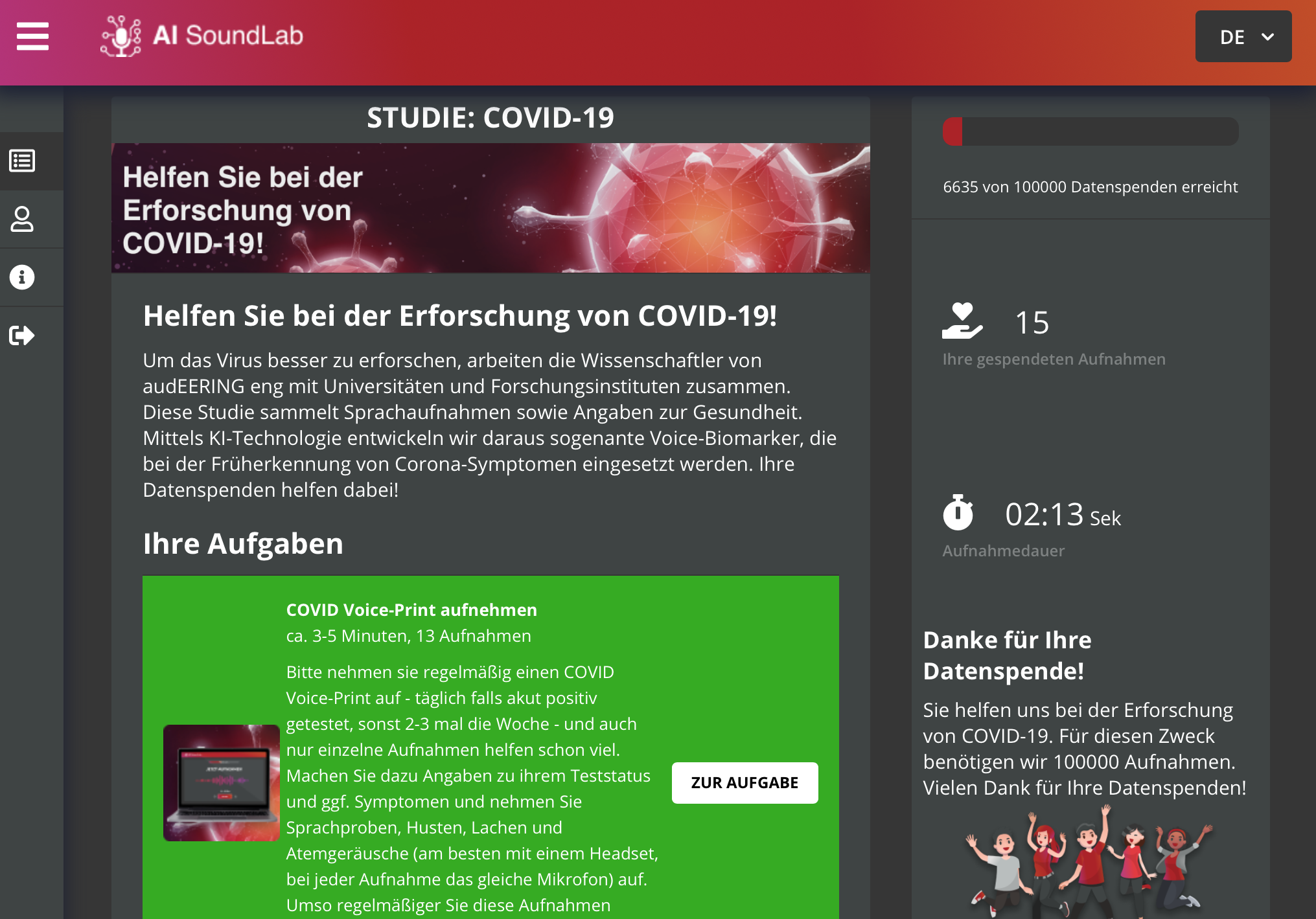

Der Zulassungsprozess ist zäh. Zu sehr greift der Datenschutz ein, da es sich um Gesundheit und damit um sensible Daten handele. Eine eingerichtete Datenspendebank von audEERING, in der mittlerweile mehr als 9000 freiwillig und anonym abgegebene Sprachproben aufgenommen worden sind, kann da nur einen Teil beisteuern (Link zur Studie: https://www.audeering.com/ai-soundlab/).

Fotos audEERING

Für den Stimmentest reicht das Mikrofon im Smartphone, das erfasste Daten an die installierte App transportiert. Es gibt keine Vernetzung, schon gar nicht mit der Cloud. Die Privatsphäre sei strikt gewahrt, betont die Chefin. Die App könne mehr Sicherheit in Zeiten gelockerter Ausgangsbeschränkungen bringen, sagt sie. „Aber in Deutschland haben wir eine bizarre Diversität, die Menschen posten persönlichste Daten oder Fotos mit neuer Haarfrisur in den sozialen Medien und geben dort wesentlich mehr preis als für die anonymen Studien.“ Der Widerstand der Gesellschaft sei enorm.

Früchte der Grundlagenforschung

Möglich wird der Test mit einer mittlerweile festgestellten hohen Zuverlässigkeit durch Stimmen-Biomarker. Die werden mittels Künstlicher Intelligenz aus Sprachaufnahmen gebildet, die im Falle einer Infektion bestimmte Symptome aufzeigen. "In Tests mit verfügbaren Daten konnten wir beispielsweise erkennen, dass sogar aus der Atmung Merkmale erkennbar sind", sagt Schuller. "Unser Ansatz kombiniert dies mit symptomatischen Sound-Events wie Husten; durch die Kombination erwarten wir so validere Ergebnisse."

Der Audio-Test suche nach einer Reihe von Indikatoren und errechne aus deren Grad des Vorhandenseins eine Wahrscheinlichkeit für die Erkrankung. Auf diese Indikatoren und deren Einfluss werde denn das Modell trainiert. "Je mehr valide Daten es bekommt, umso besser kann es lernen." Dann können auch Mutanten einen solchen Test nicht austricksen.

Das ist die Kerntechnologie von audEERING – ein Kunstname für „Intelligent Audio Engineering“. Mit ihrer Grundlagenforschung haben vier Doktoranden des Lehrstuhls Mensch-Maschinen-Kommunikation der TU München zusammen mit Dagmar Schuller eine Ausgründung gewagt. Außer der Vorstandschefin gehört Florian Eyben, Mitgründer und Technologievorstand, zum Kernteam. „Wir analysieren Emotionszustände nicht anhand von dem, was Menschen sagen, sondern wie sie es sagen“, beschreibt er die Plattform.

Angeblich haben Google und Apple Interesse

Diese haben sie in den vergangenen Jahren projektbezogen mit Kunden entwickelt. Sie kann in nahezu allen Lebenslagen eingesetzt werden. In der Marktforschung kann sie Reaktionen von Tester neuer Produkte analysieren. In der Unterhaltungselektronik findet die Sprachanalyse in Computerspielen ihren Niederschlag, in denen es nicht mehr nur um Reaktionsgeschwindigkeit geht, sondern nun auch emotionale Elemente der Spieler einfließen und zu einem zusätzlichen Feature machen.

Sprachassistenten wie Alexa oder Siri könnten nicht mehr einfach Befehle entgegennehmen, sondern diese emotional einordnen; und wenn es die richtige Wahl der Musik in der aktuellen Stimmungslage ist. Angeblich sollen Google und Apple Interesse angemeldet haben.

Das macht die Technik für die Autoindustrie interessant. BMW, Daimler, Marktforscher Ipsos und GfK, Huawei oder Red Bull sind Kunden. Großen Stellenwert hat die Gesundheit. Krankheiten wie Alzheimer, Parkinson oder Fettsucht, Depressionen und Burnout lassen sich in einem frühen Stadium über Veränderungen in der Stimme erkennen – und nun eben auch Covid-19.

Website zur Studie